-

当前位置:芯师爷

- 首页

- 热点资讯

随着大模型的落地,AI计算能力的需求在不断增长,这意味着更庞大的训练数据、更多的模型参数和更高的计算量。然而,随着AI应用最后一公里打通和业务落地,现有的芯片硬件性能提升的速度难以满足算法模型急剧增长的算力需求,这就需要新的芯片架构的突破。

2024年7月31日,亿铸科技创始人、董事长兼CEO熊大鹏博士在由深芯盟举行的“CoWoS封装与AI芯片设计与应用趋势”的直播中,发表了题为《国产大算力芯片面临的技术挑战和解决方案》的演讲,对此做出了解答。

突破有效算力天花板的两个路径

熊大鹏博士在演讲中指出,阿姆达尔定律作为硬件加速设计的基本定律,揭示了并行计算的潜力和局限性,它表明有效算力的提升取决于加速器的规模和在整个计算周期中数据搬运、缓存以及对数据做准备所消耗的百分比,即F的大小决定了有效算力的瓶颈。对于当前用于大模型的大算力芯片而言,由于架构、带宽等诸多因素的限制,F值已经超过80%甚至更高,这才是导致在传统计算模式下,算力无法突破的根本原因。

在实际应用中,需要综合考虑各种因素来优化系统性能,才能降低F值,突破有效算力天花板。熊大鹏博士认为,主要有以下两条路径:

第一条路径,从芯片层面来看,通过存算一体架构和CoWoS等先进封装技术,可以有效突破芯片本身的数据搬运瓶颈,缩短数据搬运距离和时间。其中,存算一体架构将存储和计算功能集成在一起,减少了数据在内存和处理器之间的搬运和传输延迟。通过一体化的存算融合技术,有效降低F值,成倍提升有效性能和能效。而先进封装则可以显著提升存储芯片和计算芯片间的带宽,减少数据传输延迟,降低F值。

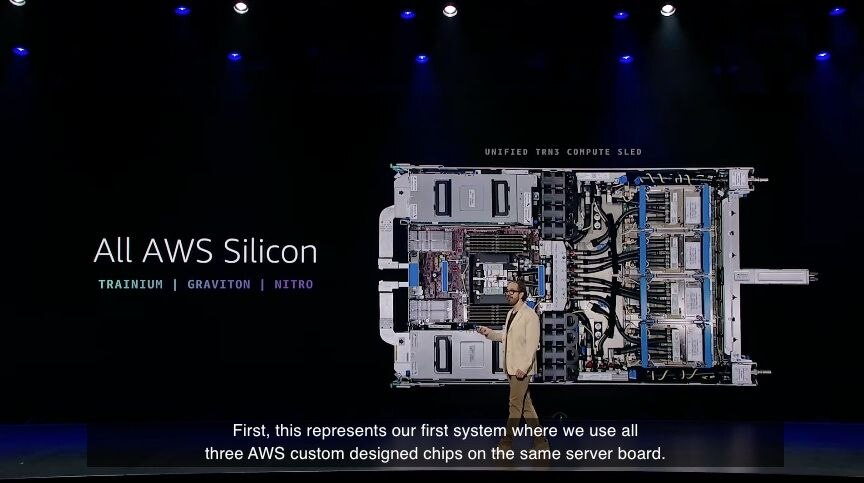

第二条路径则是在芯片和芯片之间,通过高速互联、硅光子技术等芯片互联技术,提供足够大的带宽和足够短时延,从而提高多芯片板卡或服务器整体的有效算力。例如,GH200超级计算机中每张SuperChip视为一个服务器,通过NVLINK SWITCH完成芯片间互联,使得每个GPU都可以以900GBps的速度访问其他GPU,极大地提升了有效算力。

目前,业界绝大数厂商都是在芯片和芯片间的解决方案上下工夫,通过高速互联等技术来提高算力,但是从阿姆达尔定律来看,这种方式在不改变计算架构的前提下,依然很难消除“存储墙”、“能耗墙”等问题。但要想真正解决问题,还需要从芯片架构上入手。

芯片架构创新如何突破算力天花板

在熊大鹏博士看来,目前业界存在三种芯片架构的创新逻辑,都能够突破有效算力的天花板。

第一种就是存算一体架构,即将存储单元和计算单元融合在一起,通过在存储介质中直接进行数据处理,减少了数据在存储器和处理器之间的传输,从而显著提高计算效率和能效比。熊大鹏博士表示,在存算一体架构中,F=0,芯片可以达到最大算力,是目前最理想的解决方案。但是存算一体架构目前也有几个问题需要克服:第一,存储单元的容量够不够大,尤其是当存算一体架构应用到大模型时,在提供大算力的同时,能否提供足够大的存储空间。第二,如何通过存算一体实现逻辑计算等多种计算的配合。第三,如何克服软件生态的问题。

第二种是近存计算架构,该架构是另一种将存储单元和计算单元集成在一起的技术,增加访存带宽、减少数据搬移,以提升整体计算效率。与存算一体不同,近存计算仍然属于存算分离的架构。近存计算通过将数据靠近计算单元,减小数据移动的延迟和降低功耗,是目前提升芯片性能的主流方案。但是近存计算也需要克服几个问题:第一,需要解决系统集成、架构设计空间探索、数据映射、缓存一致性和虚拟内存支持等关键问题。第二,面临着工艺成熟度、微缩性、系统集成和通信瓶颈等多方面的挑战。第三,需解决计算完备性和软件生态等关键问题。

最后一种是混合计算架构,熊大鹏博士表示,混合计算可以结合存算一体和近存计算的优点,通过不同的计算单元和存储单元的协同工作,实现更高效的计算和数据处理。相对于其他架构而言,混合计算可以通过优化存储和计算资源的分配,克服单一存算一体架构中的容量限制;并且根据任务需求动态调整资源分配,以实现最优的计算性能。可以说,混合计算通过不同架构的整合,使得支持复杂的大模型的大算力芯片的落地成为可能。

最后,熊大鹏博士强调,通过降低F值和解决芯片互联问题,可以大大提高用于大模型的大算力AI芯片的应用效果,提高其有效的算力,突破算力天花板。

对此,亿铸科技在2023年首次提出“存算一体超异构”,融合存算一体等技术,为大模型时代AI大算力芯片换道发展提供全新思路,为AI芯片产业发展贡献更具性价比、更高能效比、更大算力发展空间的AI大算力芯片发展新路径。熊大鹏博士相信,这一技术在未来将是开启算力增长第二曲线,助力产业腾飞的主要推力!

相关文章

查看更多

>>

第十四届中国电子信息博览会深圳新闻发布会成功举行

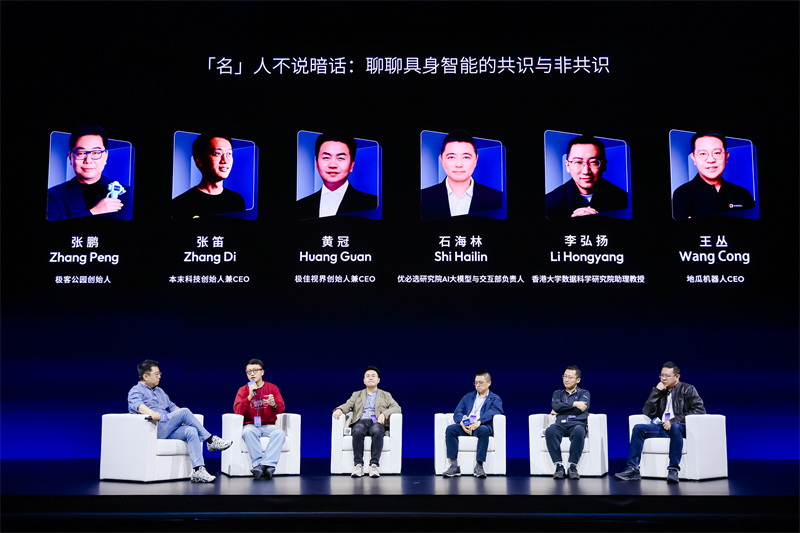

机器人产业“向高同行”:地平线携手生态伙伴迎产业百花齐放新篇章

Arm 借助融合型 AI 数据中心,重塑计算格局

发表评论 取消回复